Qzone

Qzone

微博

微博

微信

微信

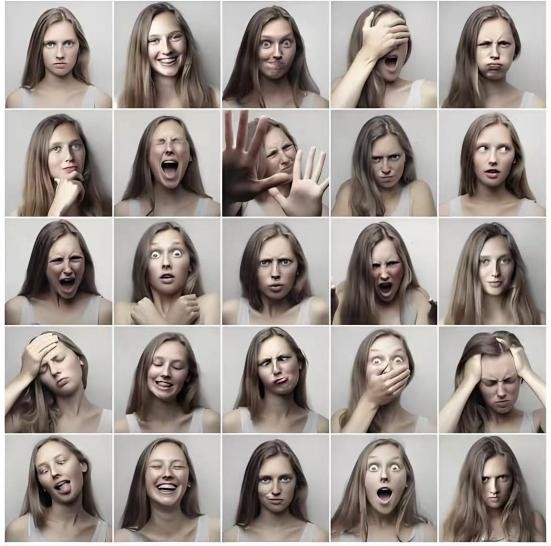

近日,新华网报道了一项关于面部表情识别内在机制的研究,引发了广泛讨论。文章指出,面部表情识别涵盖基本情绪和复合情绪的识别,其中6种基本情绪——快乐、恐惧、悲伤、愤怒、惊讶和厌恶,通常通过特定的面部表情特征表现出来,例如微笑、瞪眼或皱眉。此外,人们还能识别如内疚、羞愧等更复杂的情绪,这些情绪由多种基本情绪组合而成,表达方式更为微妙和多样化。这一机制正是连信数字大数据模型所利用的核心机制之一。情绪识别技术作为人工智能领域的重要突破方向,正深度赋能公共安全、社会治理、校园安全等关键领域。目前,连信数字在正脸情绪识别的准确率上已达到95%以上(部分情绪超过99%),居于国内第一梯队领先水平。

据了解,常规情绪识别技术在实际应用中面临两大挑战:一是使用场景受限,正脸识别难以实现无感化且易被伪装,难以持续捕捉情绪;二是实战准确度低,如校园场景中高位监控视角下,头部云服务商及AI龙头企业准确率也不尽如人意。

针对实际应用中面临的挑战,连信基于国外行业领先专家的理论自主突破创新,构建完整技术体系,通过深度学习、多模态数据处理等手段,实现高位监控视角情绪识别能力的重大突破,监控视角识别准确率达82.17%,刷新行业纪录。

高位监控视角情绪识别能力模型架构:基于深度学习框架构建,通过多层特征提取网络逐级解析面部表情细节,包括五官轮廓、肌肉动态及纹理变化等基础特征。在特征映射层,采用高维空间向量转换技术,将离散的面部信息转化为连续的情绪特征向量,消除环境噪声干扰,精准刻画细微表情差异,最终通过高级分类器和回归模型实现情绪判别。

高位监控视角情绪识别能力数据处理机制:支持静态图像(如监控抓拍)与视频抽帧(25fps以上)两种数据输入模式,确保系统在不同场景下的兼容性。

高位监控视角情绪识别能力大规模训练数据与泛化能力:连信数字整合了多源数据集,包括CK+、AffectNet、FANE面部表情、EmoDB情感数据集、FACES数据样本等公开数据集,以及实验室环境下采集数据和业务数据,每种情绪类型的样本量均超10万张,确保模型的准确性和泛化能力。

高位监控视角情绪识别能力系统性能优化:连信数字对计算图及内存调度进行了优化,单次推理仅需20ms(服务器端),结合优化的通信链路,整体接口响应时间为100ms,保证系统在多并发环境下依然具备低延迟、实时响应能力。经过真实场景数据测评,高位监控视角表情识别准确率总体达到82.17%,在行业中已达到领先水平。

目前连信的“高位监控视角情绪”识别技术可作为风险预警指标,为教育、公安、司法、检察院、政法委、医疗等领域提供情绪洞察和科学支撑。在教育场景中,系统利用高位摄像头实时分析学生负性情绪,预警心理风险并提供辅助性建议;在公安审讯场景中,实时分析嫌疑人情绪状态,识别异常情绪信号;在企业管理中,监测员工情绪压力和冲突,预防心理危机,提升管理效率。