Qzone

Qzone

微博

微博

微信

微信

当你在手机上唤醒语音助手,或是在笔记本电脑上处理一份包含复杂图表的文档时,这些看似简单的操作背后,实则涉及大量的数据运算与处理流程。端侧设备如何在本地完成这些AI任务,而不依赖云端的持续响应,这一问题正在成为技术领域关注的焦点。

【端侧AI推理的实际价值】

端侧AI推理可带来多方面的实际价值。在本地处理数据而非将数据发送到云端的方式下,端侧设备可提供速度更快、响应更灵敏的AI体验。这种处理方式能够缩短网络延迟,减少对网络连接的依赖,同时在一定程度上加强隐私保护。此外,本地数据处理还可避免在端侧设备和数据中心之间不断地来回传输大量数据集,从而能够节省一定能源。在以前,端侧设备严重依赖云服务器来完成自动驾驶等任务,面临着网络延迟和连接中断等风险。

据Gartner预测,2025年支持生成式AI的端侧设备硬件支出将增长99.5%,达到39亿美元。这一数据反映出端侧AI应用领域的市场需求正在快速扩大。从手机、PC到汽车领域,端侧设备的推理能力正在迅速发展,使AI工作负载能够更接近数据来源运行。

【内存与存储技术在端侧AI中的作用】

内存瓶颈可谓一个重大问题,在模型训练和推理阶段尤其如此。虽然GPU、TPU和NPU等计算单元至关重要,但AI工作负载往往在计算资源耗尽之前就会遭遇内存墙。高带宽内存HBM可有效缓解云端的瓶颈,而美光LPDDR5X则为端侧设备提供了高带宽与高能效。这些内存技术可确保AI工作负载能高效快速执行,无论它们位于端侧还是云端。

美光的产品基于业界前沿制程节点,能效表现卓越,其中采用美光前沿1γ制程节点的产品更在业界同类产品中脱颖而出。在端侧与云端双重环境中管理AI工作负载时,从端侧AI到物联网设备,各行各业的客户都依靠美光的优势地位与专业积淀,来有效应对这些数据挑战。

【分布式AI模式下的端侧与云端协同】

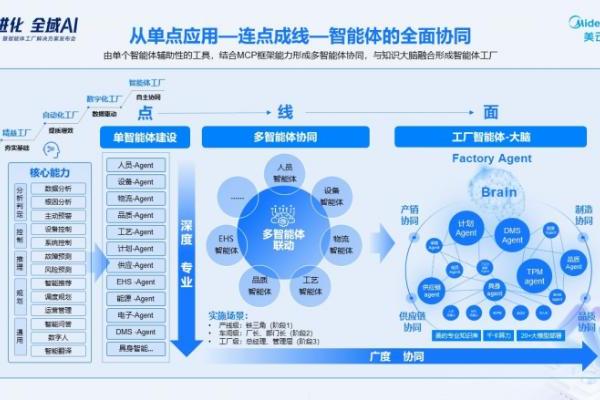

尽管端侧计算发展迅猛,但云仍然是AI生态系统的重要组成部分。融合便捷端侧计算与大规模云计算的分布式模型,正成为AI工作负载的理想解决方案。代理式AI即无需人工干预即可自主做出智能决策的AI系统进一步加强了端侧与云端的协同。AI代理可驻留在终端设备中,当遇到无法完全解答的问题时,它会立即向云端或数据中心中更复杂、更专业的AI模型寻求答案,然后为用户返回更精准的响应。

随着AI模型日趋复杂,它们对内存和存储容量的需求与日俱增。无论是端侧设备还是云端基础设施,都需要支持这些不断扩展的模型,同时不影响性能。美光的内存和存储解决方案专为满足这些需求而设计,可提供AI应用所需的大容量与高速度。

【应用场景中的技术配置考量】

随着AI持续演进,内存与存储在端侧应用及设备中的重要性不容忽视。无论是手机、PC和汽车领域的企业,还是工业与机器人行业的先行者,都必须优先考虑这些核心器件,方能确保其AI工作负载的成功运行。LPDDR5X等低功耗DRAM可提供实时处理所需的带宽,而快速、高效的存储可用于处理模型数据和推理结果。

美光始终提供快速、高效、可靠的解决方案。美光的技术不仅能存储数据,更能将数据转化为切实可行的智能洞察。在端侧AI应用场景中,从消费电子设备到工业领域的各类智能终端,这些内存与存储产品构成了支撑AI功能运行的基础架构。

TOM2026-02-08 22:1502-08 22:15