Qzone

Qzone

微博

微博

微信

微信

5月17日,腾讯云在北京举办的生成式AI产业应用峰会上公布大模型研发、应用产品的系列进展。腾讯集团高级执行副总裁、云与智慧产业事业群CEO汤道生表示,腾讯始终以“产业实用”作为发展大模型的核心战略,通过打造高性能的模型、高效率的工具平台、高敏捷的场景应用、高可用的算力基础设施,以及强安全的模型环境,构建离产业最近的AI。

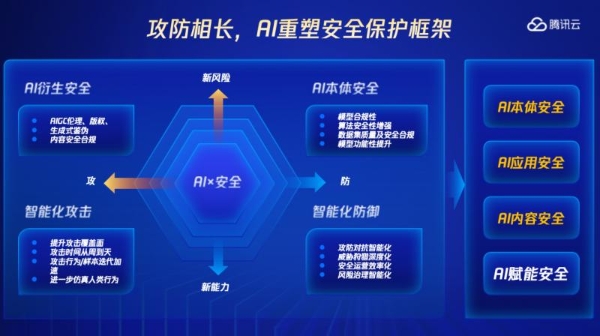

围绕AI带来的全新安全挑战,腾讯云在会上发布了AI安全保护框架,以及全链路的内容安全解决方案和数据安全解决方案,护航企业拥抱生成式AI从模型训练、内容生成到事后运营全过程的安全建设,护航产业发展。

(腾讯安全总经理周斌在大会现场发表主题演讲)

生成式AI为许多行业的创新和发展提供了新的工具和视角,但其带来的安全威胁也让众多企业倍感担忧。相关研究数据显示,ChatGPT发布后,钓鱼邮件环比增长260%且平均语言复杂度提升17%,攻击者利用生成式AI增加的社会工程攻击量达135%,这些新风险均导致企业安全需求激增。根据普华永道调研显示,77%的CEO担心AI增加网络安全风险。

腾讯安全总经理周斌认为,AI和安全一直以来都在互相影响,尤其是在生成式 AI爆火以来,攻击方和防守方都在利用AI提升智能化水平。这个过程中,也会产生专属于大模型的新风险,尤其是AI本体安全,以及生成式AI“智能涌现”对数字内容、版权等方面的衍生安全冲击。

因此,防守方应重新建立AI本体安全、AI应用安全、AI内容安全的AI应用保护框架,覆盖AI从第一条数据训练到最终上线运营全过程安全。同时,企业还应提升安全体系的AI含量,让安全专家和机器协同作战,智能化应对安全威胁。

周斌表示,无论哪种技术的伴生安全,其实都需要多方协同。在企业拥抱生成式AI的过程中,以腾讯为代表的大模型建设方,需要保障AI本体安全;企业基于腾讯的大模型构建原生AI应用时,需要关注模型从开发、测试、部署到运行等完整生命周期内的应用安全,“同时,双方还需要携手共建AI内容安全防线”。

周斌认为,相比于其他技术和业态,生成式AI的特征是始终围绕“数据”和“内容”展开,每一条训练数据和生成内容,都在检验全套安全体系是否有效。其中内容安全不仅考验底线类的涉黄涉暴等违规内容,还要应对虚假信息泛滥、个人内容版权侵权、文化偏见歧视、伦理道德背离等全新挑战。

腾讯云对此打造了天御AIGC全链路的内容安全解决方案,提供包含审校服务、安全专家服务、机器审核服务、版权保护服务、客户体验管理五大服务体系,包含风险场景定义、风险语料库服务、语料版权检测、输出价值观检测、业务传播风险监测等能力,覆盖生成式AI应用从模型训练到内容生成到事后运营全过程的内容安全建设。

腾讯安全依托过去20多年的安全运营经验,积累了丰富的违规样本以及十几种定制识别服务,可以结合行业场景为企业的内容安全建设“量体裁衣”。腾讯云天御风控还和对象存储、云直播、云点播、实时音视频等云上工具打通,让企业在云上一次接入即可完成整套审核,效率大幅提升。

目前,腾讯云天御AIGC内容安全解决方案已在AI问答、数字人、创作助手、代码生成、娱乐社交、AI客服等各种场景中落地,覆盖主流生成式AI应用生态,护航各行各业内容安全。

在内容合规要求外,生成式AI还面临数据安全风险,模型和数据都会成为潜在的攻击目标,数据类型多样及规模大也导致数据安全治理难度加大。相比于传统过滤掉有害数据的保护措施,生成式AI的“从无到有”的特性显著加剧了数据安全挑战。

因此,为防范数据安全问题造成的隐私侵犯、经济损失、法律责任、声誉损失等系列问题,需要对数据工程师、算法工程师等人员做好身份认证、数据访问控制以及操作管控,对数据做好防篡改、敏感数据去标识化、以及数据行为审计和异常监测。

腾讯云针对AIGC场景和数据特点开发,打造数据安全治理解决方案,通过对大模型的用户、实体、模型文件实施分级别的访问控制,实现权限分离。同时,腾讯云通过数据安全治理中心、数据安全防护网关、机密计算平台等产品能力,实现大模型业务全流程从数据采集、数据处理、训练、精调、发布、推理到应用的过程中,海量数据和大模型的完整性和保密性。

目前,该方案已实现99.99%敏感数据识别准确度,积累了超200种的数据分类以及300多个风险检测模型,能支持企业海量数据的敏感度识别和安全防护、审计溯源。

除此之外,周斌在发布会上还公布了腾讯云在安全运营、风控建模、漏洞修复等基于大模型赋能安全场景的探索,致力于帮助企业提升安全攻防效率。周斌表示,未来,腾讯云将基于领先技术让千行百业无惧安全威胁,安心拥抱AI,激发应用价值。